Gerardo Demarco

Ingeniero en comunicaciones UBA. Experto en TICS. Director curso Estrategia de IA en salud (IDHS).

Mariángeles Domínguez

Médica. Magíster en Gerencia y Administración de sistemas y Servicios de Salud. Director curso Estrategia de IA en salud (IDHS).

“Inteligencia Artificial en Salud: Cómo Maximizar su Potencial y Limitar sus Riesgos”

La inteligencia artificial (IA) generativa está transformando el cuidado de la salud, con un potencial enorme para mejorar la calidad de atención y reducir tareas rutinarias. Sin embargo, su uso responsable y seguro exige marcos éticos, control profesional y protección de la privacidad de los pacientes para evitar riesgos y asegurar que la tecnología funcione como apoyo y no reemplazo de la actividad profesional.

El uso de IA en el campo de la salud no es nuevo. La FDA ha habilitado el uso en dispositivos médicos desde el año 97, con incremento exponencial en los últimos años. A la fecha la FDA ha otorgado permisos para 950 dispositivos, mayoritariamente relacionados con la radiología. En estos últimos años el escenario se ha revolucionado con la aparición de la Inteligencia Artificial Generativa (IA Gen).

El éxito demostrado en la generación de texto e imágenes, así como la amplia disponibilidad de plataformas multimodales (como Gemini, Chat GPT, Copilot, Llama), amplifica la expectativa de su uso por parte de pacientes, estudiantes y profesionales de la salud. Por tal motivo tanto la comunidad científica como las grandes compañías de tecnología (Google, Amazon, Nvidia, Open AI, Microsoft), dedican cada vez mayores recursos para su desarrollo.

Los resultados publicados a la fecha acerca de estas tecnologías muestran un prometedor uso en la generación de resúmenes, notas de derivación y notas explicativas para los pacientes. Su incorporación a los procesos de la gestión de la salud reducirá tareas altamente rutinarias de los profesionales de la salud, brindándoles más oportunidades para mejorar la calidad de atención al paciente. Si bien es altamente prometedor, el uso de IA generativa para el diagnóstico aún requiere de mayores estudios.

Toda tecnología incipiente requiere, para su uso seguro, pruebas por parte de la comunidad científica y publicación de resultados. Para que la inteligencia artificial alcance todo su potencial y minimice riesgos, es además necesario salvaguardar la autonomía y asegurar el control por parte del profesional de la salud interviniente.

Introducción

Bill Gates afirma que el año 2022 debe ser considerado el año en que “despertó” la Inteligencia Artificial. En dicho año el público general pudo acceder gratuita y masivamente a las plataformas de IA Generativa como Chat GPT, Gemini, Copilot, Llama, etc.

La IA generativa es una categoría de técnicas de IA en la que los algoritmos pueden generar contenido nuevo, como texto, imágenes o vídeo.

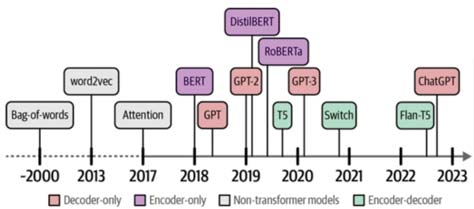

Luego de los extraordinarios avances alcanzados por Geoffrey Hinton[1] e Ilya Sutskever[2] en redes neuronales[3], en el año 2017 un trabajo publicado por varios miembros de Google Brain y de la Universidad de Toronto (“Attention is All you need”[4]) revolucionó el campo del Procesamiento del Lenguaje Natural (PLN).

Como vemos en el gráfico la evolución de las técnicas de PLN derivó a lo que se denomina “Large Language Models” (LLM). Estos modelos pueden alcanzar la impresionante cifra de cientos de miles de millones de parámetros, y son entrenados con un vasto “corpus” de información mayoritariamente extraída de internet. La extensión de estos modelos le permite “aprender” patrones lingüísticos complejos y generar texto coherente a partir del contexto dado. Estos extraordinarios resultados son posibles gracias a una arquitectura de Redes Neuronales denominada “Transformers”[7]. Este concepto se ha extendido al uso de imágenes y video dando lugar a los actuales LMM (Large Multimodal Models).

Se ha pronosticado que los LMM tendrán un amplio uso y aplicación en la atención sanitaria, la investigación científica, la salud pública y el desarrollo de fármacos. Estos modelos no sólo pueden realizar las funciones que ya conocíamos de la IA y los LLM (responder en lenguaje natural de una forma coherente, expresiva y convincente, generar resúmenes, notas de derivación, clasificar texto , generar recomendaciones) sino que pueden también interpretar imágenes, videos y voz. Su uso podría extenderse a diversos campos como el entrenamiento para cirugía, detección de cáncer por imágenes, enfermedades a través del análisis de la tos, análisis en tiempo real mediante el escaneo de parámetros físicos, etc.

Según lo expuesto en la guía publicada por la OMS acerca del uso de LMM titulada Ethics and Governance of Artificial Intelligence for Health[8], la IA (Inteligencia Artificial) se refiere a la capacidad de los algoritmos y herramientas para aprender de los datos de modo que puedan realizar tareas automatizadas (como analizar imágenes, resumir textos, traducir, clasificar, pronosticar, recomendar, etc) sin necesidad que un humano programe en sí cada paso.

Dichos algoritmos “aprenden” a partir de millones de datos. En el proceso de aprendizaje el modelo ajusta sus parámetros (¡en algunos casos cientos de miles de millones de parámetros!). En el contexto de IA “aprender” significa minimizar el error de aquello que se quiere predecir, sea un número, una imágen o un texto.

Una IA generativa generará una palabra a la vez, de acuerdo con algún criterio de probabilidades que surgen del contexto del “prompt” (el prompt es el texto que se introduce en las aplicaciones como GPT para obtener un resultado). Uno de los efectos no deseados de la IA generativa son las “alucinaciones” (información incorrecta, inconsistente o inventada), lo cual es inaceptable en el campo del diagnóstico médico. Aunque estas aplicaciones nos brindan extraordinaria experiencia interactiva, con diálogos coherentes, consistentes, y convincentes, de ninguna manera se puede aseverar que dicha información sea “verdadera”.

Para mitigar estos efectos, el uso eficiente de los LLM requiere de utilizar técnicas de “prompting” que mejoran y dan resultados más precisos. Algunas guías de recomendación las podemos encontrar en

OpenAI: https://platform.openai.com/docs/guides/prompt-engineering

Google: https://cloud.google.com/discover/what-is-prompt-engineering

Microsoft: https://support.microsoft.com/en-us/topic/learn-about-copilot-prompts-f6c3b467-f07c-4db1-ae54-ffac96184dd5

AWS: https://aws.amazon.com/what-is/prompt-engineering/

En general se recomienda:

- Asignar un rol. “Eres un profesor universitario”

- Dar una tarea/instrucción. “Realizar un resumen”; ”Clasificar las siguientes imágenes”.

- Dar un contexto: “Extraer los puntos más relevantes que permitan proveer un rápido entendimiento”.

- Dar un formato: “Crear una tabla con las siguientes columnas”

- Definir una audiencia: “La audiencia es el alumnado del primer año del curso de medicina”.

- Definir el tono: “Utilizar lenguaje formal, adecuado para una publicación científica”.

Otras técnicas de prompting consisten en dar ejemplos y cadenas de razonamiento. Por ejemplo, para generar una cadena de razonamiento podemos comenzar el prompt diciendo: “Pensar paso a paso”. O bien para generar un árbol de pensamiento podemos ingresar “supongamos que hay 3 expertos de diferentes disciplinas”.

Especialmente en el contexto de LLM para el uso de cuidado de la salud se requiere de dos herramientas a incorporar al diseño de la solución que ayudan a minimizar el error:

- búsqueda en línea: permite contar con la última información relevante de la especialidad ya que los modelos están entrenados con información pasada.

- RAG (Retrieval-Augmented Generation)[9]. La generación mejorada por recuperación (RAG) es el proceso de optimización de la salida de un modelo lingüístico de gran tamaño, de modo que haga referencia a una base de conocimientos autorizada fuera de los orígenes de datos de entrenamiento antes de generar una respuesta.[10]

El potencial LMM aplicados al área de Salud

Actualmente podemos encontrar ya varias aplicaciones disponibles para el cuidado de la salud que utilizan LMM (Large Multimodal Models). La OMS ha diseñado su propio asistente virtual SARAH), para dar recomendaciones de bienestar. El mismo requiere permisos de cámara y micrófono además de la aceptación de políticas

https://www.who.int/es/campaigns/s-a-r-a-h

AWS cuenta con HealthScribe[11] para “crear automáticamente notas clínicas a partir de conversaciones entre el paciente y el médico mediante el uso de IA generativa”.

Microsoft ofrece Azure Health Bot que “permite que los desarrolladores de organizaciones encargadas de la salud creen e implementen, a gran escala, experiencias conversacionales de asistencia médica que cumplan con las normativas basadas en inteligencia artificial”.[12]

La Clínica Mayo desarrolló OpenEvidence[13] con la misión de “organizar el conocimiento médico mundial y hacerlo más útil, abierto, accesible y comprensible”.

Es importante recalcar que ninguna de estas aplicaciones está recomendada para realizar diagnósticos médicos. Las dos primeras están focalizadas en realizar resúmenes y la última en acceder a información actualizada mediantes consultas en lenguaje natural.

Google ha publicado recientemente los resultados de la evaluación de su modelo multimodal Gemini ajustado para el área de Salud (Med Gemini[14]).

Algunas de sus conclusiones son:

- Demuestra razonamiento avanzado en tareas basadas en texto, alcanzando un 91.1% de efectividad en la tarea de responder a preguntas cerradas sobre el dataset Med QA[15]

- Demuestra la capacidad de generar texto de formato largo para generar resúmenes clínicos posteriores a la visita, generar notas de derivación de médicos y simplificación médica.

- Demuestra comprensión multimodal en diversas tareas en desafíos con video e imágenes y preguntas cerradas.

El estudio muestra ejemplos sintéticos (simulados) de interacción mediante imágenes y videos, respondiendo con recomendaciones tanto para pacientes, estudiantes y profesionales de la salud. Advierte específicamente sobre la necesidad de más rigurosas evaluaciones más allá de los benchmarking antes de ser utilizado aún en etapas de diagnóstico.

El potencial para diversas aplicaciones despierta el interés de la industria de la tecnología. Su adopción requiere que la comunidad científica y los entes reguladores provean guías claras para el diseño de protocolos de prueba y desempeño.

Los riesgos del uso de LMM para el cuidado de la salud

Entrenamiento con datos de baja calidad: Si los datos utilizados durante son incorrectos, falsos, incompletos, imprecisos o incoherentes, entonces el resultado será de mala calidad. El utilizar fuentes reconocidas, autorizadas, y debidamente controladas por profesionales competentes es requisito indispensable para el entrenamiento de un LLM.

Datos de entrenamiento sesgados: Un LMM entrenado en un conjunto de datos sesgado generará recomendaciones sesgadas.

Interpretabilidad y explicabilidad: Las redes neuronales, las arquitecturas de “transformers” que están en la base del desarrollo de los LMM generan resultados que son difíciles de interpretar y explicar. Por lo que cualquier error que se produzca en un tratamiento derivado de la aplicación de un LMM dificultará la asignación de responsabilidades claras, y de oportunidades de mejora en los tratamientos.

Generación de contenido dañino: como se mencionó anteriormente, los LMM pueden generar “alucinaciones” (potencialmente dañinas) aún cuando se las intente mitigar con las técnicas más avanzadas actuales. Incluso existe el riesgo de que los modelos sean “atacados” con información falsa o interesada.

Acceso indebido a información personal del paciente: Muchos de nosotros utilizamos tecnología de IA diariamente y sabemos que les damos acceso a grandes volúmenes de información personal. Al escanear datos biométricos al usar relojes inteligentes o apps de celulares, o al consultar asistentes virtuales damos conformidad a sus políticas de privacidad. Imágenes, voz, datos médicos, datos personales: cuantos más datos proporcionamos mejor la experiencia interactiva que nos ofrecen. Estos datos otorgados se almacenan en la nube para luego ser recopilados en una base de datos y ser usados para entrenar el modelo que ese dispositivo está diseñado para dar recomendaciones o respuestas. Toda esta información, si no es debidamente anonimizada, puede ser utilizada por terceros para usos no consentidos por el paciente.

Ante esta situación la adopción en el ambiente del cuidado de la salud requerirá marcos regulatorios claros que puedan ser utilizados por los profesionales como guías en los procesos de atención médica.

Cómo limitar riesgos en base a los principios éticos de la OMS[16].

A medida que la IA continúa evolucionando y desempeñando un papel más destacado en la atención sanitaria, surgen recomendaciones para su uso seguro.

Con el fin de limitar los riesgos y maximizar las oportunidades intrínsecas al uso de la IA para la salud la OMS propugna un uso seguro y ético de la inteligencia artificial. Para ello propone un conjunto de principios éticos que deben inspirar a la regulación y gobernanza de la IA.

- Proteger la autonomía: Los seres humanos debemos mantener el control de los sistemas sanitarios y de las decisiones médicas; La privacidad y la confidencialidad deben protegerse. Los pacientes deben dar un consentimiento informado válido a través de marcos legales apropiados para la protección de datos.

- Promover el bienestar y la seguridad de las personas y el interés público: Los diseñadores de tecnologías de IA deben cumplir los requisitos reglamentarios de seguridad, precisión y eficacia para casos de uso o indicaciones bien definidos. Deben disponerse de medidas de control de calidad en la práctica y de mejora de la calidad en el uso de la IA.

- Garantizar la transparencia, la claridad y la inteligibilidad: La transparencia exige que se publique o documente información suficiente antes del diseño o el despliegue de una tecnología de IA. Dicha información debe ser fácilmente accesible y facilitar una consulta y un debate públicos significativos sobre cómo se diseña la tecnología y cómo debe o no debe utilizarse.

- Promover la responsabilidad y la rendición de cuentas: Aunque las tecnologías de IA realizan tareas específicas, es responsabilidad de las partes interesadas garantizar que se utilicen en las condiciones adecuadas y por personas debidamente formadas. Deben existir mecanismos eficaces para el interrogatorio y la reparación de las personas y los grupos que se vean afectados negativamente por decisiones basadas en algoritmos.

- Garantizar la inclusividad y la equidad: La inclusión exige que la IA para la salud se diseñe de manera que fomente el uso y el acceso más equitativos posibles, independientemente de la edad, el sexo, el género, los ingresos, la raza, el origen étnico, la orientación sexual, la capacidad u otras características protegidas por los códigos de derechos humanos.

- Promover una IA con capacidad de respuesta y sostenible: Los diseñadores, desarrolladores y usuarios deben evaluar de forma continua y transparente las aplicaciones de IA durante su uso real para determinar si la IA responde de forma adecuada y apropiada a las expectativas y requisitos.

Los sistemas de IA también deben diseñarse para minimizar sus consecuencias medioambientales y aumentar la eficiencia energética.

Conclusiones

La maximización del enorme potencial que nos provee la IA Generativa requiere minimizar los riesgos implícitos derivados de la aplicación de la tecnología.

Con el fin de garantizar el bienestar de las personas y los pacientes en el largo plazo es necesario que reguladores, desarrolladores, diseñadores, usuarios y profesionales de la salud mantengan la centralidad del ser humano en todo el proceso. Se debe tener especial cuidado en mantener la privacidad de datos sensibles personales y asegurar el entrenamiento de los modelos con conjuntos de datos que contemplen la diversidad y eviten sesgos. La comunidad científica debe tener acceso a la documentación del diseño de las aplicaciones para permitir la transparencia, asegurar la aplicabilidad de los modelos utilizados y permitir la asignación de responsabilidades.

La inteligencia artificial transformará el modo en que trabajamos en el cuidado de la salud en formas que aún no podemos prever en su totalidad. Recién estamos en los inicios de estos profundos cambios. Es responsabilidad de todos conducirlos con principios éticos que aseguren su uso como una herramienta de soporte y no para el reemplazo de la actividad profesional.

NOTAS

- Geoffrey Hinton, considerado el padre de la Inteligencia Artificial y recientemente galardonado con el premio Nobel de Física, sostiene que la precisión de la IA ya es comparable a la de los radiólogos a la hora de comprender lo que sucede en las imágenes médicas.

- Ilya Sutskever, co fundador de Open AI y de Safe Superintelligence Inc., pronostica que en un futuro una IAG (Inteligencia Artificial General) diseñada para ser un médico, tendrá un conocimiento completo de toda la literatura médica, miles de millones de horas de experiencia clínica, estará siempre disponible y será extremadamente económica.

- https://d2l.ai/index.html

- Ashish V. et al. (2017). Attention is All You Need. https://arxiv.org/abs/1706.03762

- https://huggingface.co/learn/nlp-course/chapter1/2?fw=pt

- Jay A. and Maarten G. (2024) Hand-On Large Language Models

- Para profundizar en los conceptos de “Attention” y “Transformers” se recomienda la lectura de https://jalammar.github.io/illustrated-transformer/

- World Health Organization (2024) Ethics and governance of artificial intelligence for health. Guidance on large multi-modal models.

- Patrick L. et al. (2020) Retrieval-Augmented Generation for Knowledge-Intensive NLP Tasks https://arxiv.org/abs/2005.11401

- https://aws.amazon.com/es/what-is/retrieval-augmented-generation/

- https://aws.amazon.com/es/healthscribe/

- https://azure.microsoft.com/es-es/products/bot-services/health-bot

- https://www.openevidence.com/

- Khaled S. et al. (2024) Capabilities of Gemini Models in Medicine https://arxiv.org/pdf/2404.18416

- Respuesta a preguntas de opción múltiple basadas en los exámenes de licencia médica de los Estados Unidos (USMLE).

- WHO, ibid.